Jak wybrać kartę graficzną

Którego producenta wybrać: NVIDIA, Radeon czy Intel?

Rynek kart graficznych jest zdominowany przez dwa obozy: zieloną NVIDIA i czerwoną AMD/Radeon. Historycznie rzecz biorąc, NVIDIA była siłą napędową branży, popychającą technologie do przodu. Sprzętowe śledzenie promieni, sztuczne skalowanie DLSS, system interpolacji Frame Gen to pierwsze, co przychodzi na myśl. Najnowsze generacje kart graficznych firmy okazały się dość drogie, ale cokolwiek by nie powiedzieć, jest to najlepsza opcja pod względem wydajności/stabilności. Projektanci, twórcy treści multimedialnych, twórcy gier i inni przedstawiciele branży kreatywnej cenią produkty NVIDIA nie bez powodu.

Radeon ma dość interesującą rolę. Z jednej strony firma zawsze znajduje się pozycji doganiającego. Z drugiej strony wciela się w rolę Prometeusza, który przynosi graczom darmowe odpowiedniki konkurencyjnych technologii. Tylko w ciągu ostatnich 3 lat „czerwoni” wprowadzili swoje odpowiedzi DLSS, Frame Gen i Anti-Lag, które nie wymagają do prawidłowego działania oddzielnych rdzeni neuronowych i tensorowych. Jednocześnie ceny kart graficznych AMD są często nieco niższe niż odpowiedników firmy NVIDIA. Chociaż w większym stopniu zależy to od konkretnego modelu.

W 2022 roku Intel próbował przełamać dualizm swoją linią kart graficznych Arc, ale jej debiut trudno nazwać sukcesem z tysiąca różnych powodów. Jest nadzieja, że z czasem inżynierowie firmy wszystko naprawią, ale na razie lepiej patrzeć w stronę NVIDII i Radeona.

Do czego właściwie służy karta graficzna?

Karty graficzne dzielą się na dwa rodzaje: profesjonalne i gamingowe. Profesjonalne karty graficzne są zoptymalizowane pod kątem złożonych zadań graficznych, takich jak renderowanie, modelowanie i praca z dużymi ilościami danych. W większości przypadków pracują one pod kontrolą specjalnych sterowników, a wraz z kartą graficzną dostarczane jest oprogramowanie a la NVIDIA Studio. Z kolei karty graficzne do gier są zoptymalizowane pod kątem szybkiego przetwarzania grafiki w czasie rzeczywistym z wysoką jakością obrazu i płynną animacją.

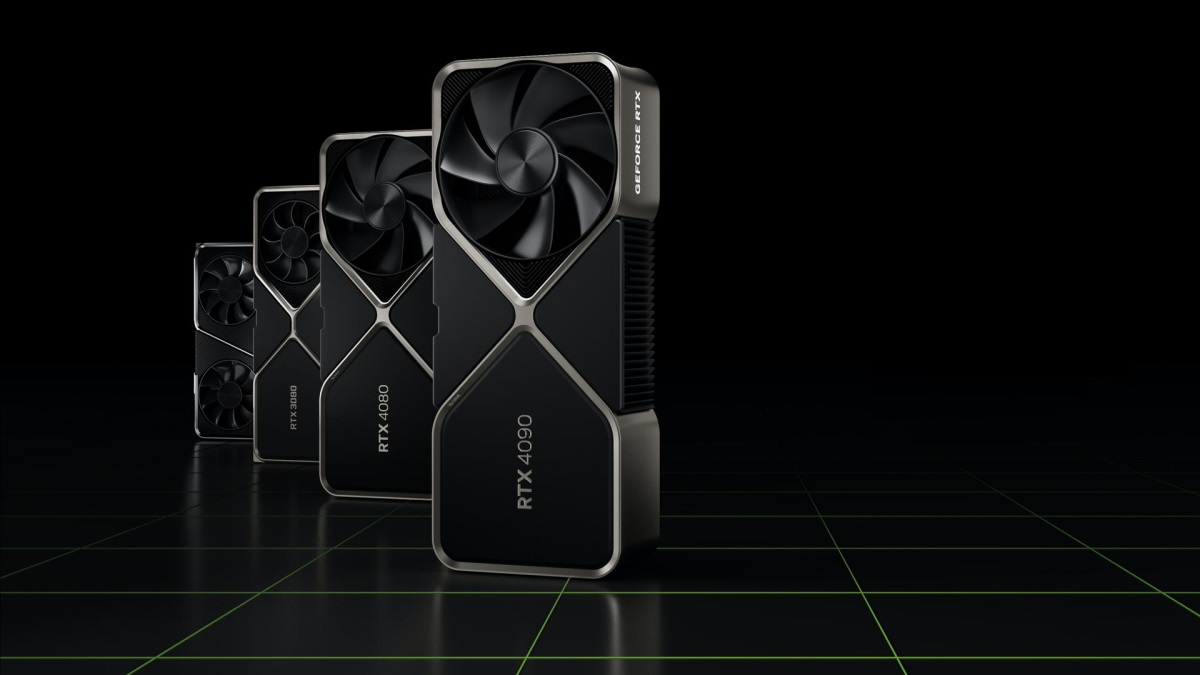

Jednak po głośnym debiucie kart graficznych NVIDIA RTX 3000 i 4000 granice się zatarły i najwyższej klasy GPU poziomu GeForce RTX 3080/3090/4080/4090 są obecnie aktywnie wykorzystywane w studiach na całym świecie do pracy z silnikami gier, przy tworzeniu animacji 3D, obróbce treści wideo, trenowaniu sieci neuronowych i wielu innych złożonych i wymagających dużej ilości zasobów zadań.

Jeśli chodzi o najprostsze zadania, takie jak teksty, dokumenty, skrzynka pocztowa, YouTube, można obejść się procesorem z wbudowaną grafiką.

Którą generację GPU wybrać?

Ostatnie generacje GPU dokonały imponującego skoku wydajności, o kilka rzędów wielkości wyprzedzając swoich poprzedników. Umowna GeForce GTX 1650 daje porządną liczbę klatek na sekundę nawet podczas grania w gry AAA, ale nie będzie to najprzyjemniejsze doświadczenie. Na przykład w najlepszej grze roku 2023, Baldur's Gate 3, ta karta jest w stanie zapewnić pożądane 50 – 60 FPS w rozdzielczości 1080p, ale ustawienia graficzne będą musiały zostać obniżone do minimum, a liczba klatek na sekundę znacznie spadnie podczas bitew i odwiedzania lokacji zapchanych NPC-ami.

Biorąc pod uwagę, że kartę graficzną kupuje się zwykle na kolejne 3 – 4 lata, nasuwa się pytanie: czy warto oszczędzać? Nie warto, skoro poprzednie generacje GPU nie staniały: na przykład wciąż niezwykle popularna GeForce RTX 3070 Ti kosztuje teraz około 500 dolarów przy zapowiedzianej cenie 599 dolarów. Minus 100 dolarów w 2 lata to wątpliwa obniżka, biorąc pod uwagę tempo starzenia się akceleratorów wideo.

Naszym zdaniem taka oszczędność ma sens tylko wtedy, gdy liczy się każdy grosz i chcesz zbudować niedrogi PC do gier z niedrogich podzespołów w cenie przenośnej konsoli Steam Deck. W tym przypadku połączenie umownego Ryzena 5 5500, budżetowej płyty głównej i używanego Radeona 5700 XT może wyglądać na naprawdę interesującą opcję, ale sam zestaw będzie ograniczony pod względem modernizacji, a wielu szczególnie wymagających gier, takich jak Alan Wake 2, Starfield i A Plague Tale Requiem raczej nie będą działać płynnie.

Ray tracing – konieczny czy nie?

Ray tracing w grach komputerowych to technologia renderowania, która pozwala tworzyć dokładniejsze i bardziej realistyczne cienie i oświetlenie, w tym miękkie cienie, które w naturalny sposób zmieniają intensywność i krawędzie w zależności od odległości i kształtu obiektów blokujących światło. W teorii technologia ta znacznie upiększa obraz dzięki bardziej realistycznemu oświetleniu i wszechobecnym odbiciom w szybach, lustrach, kałużach i przejeżdżających samochodach.

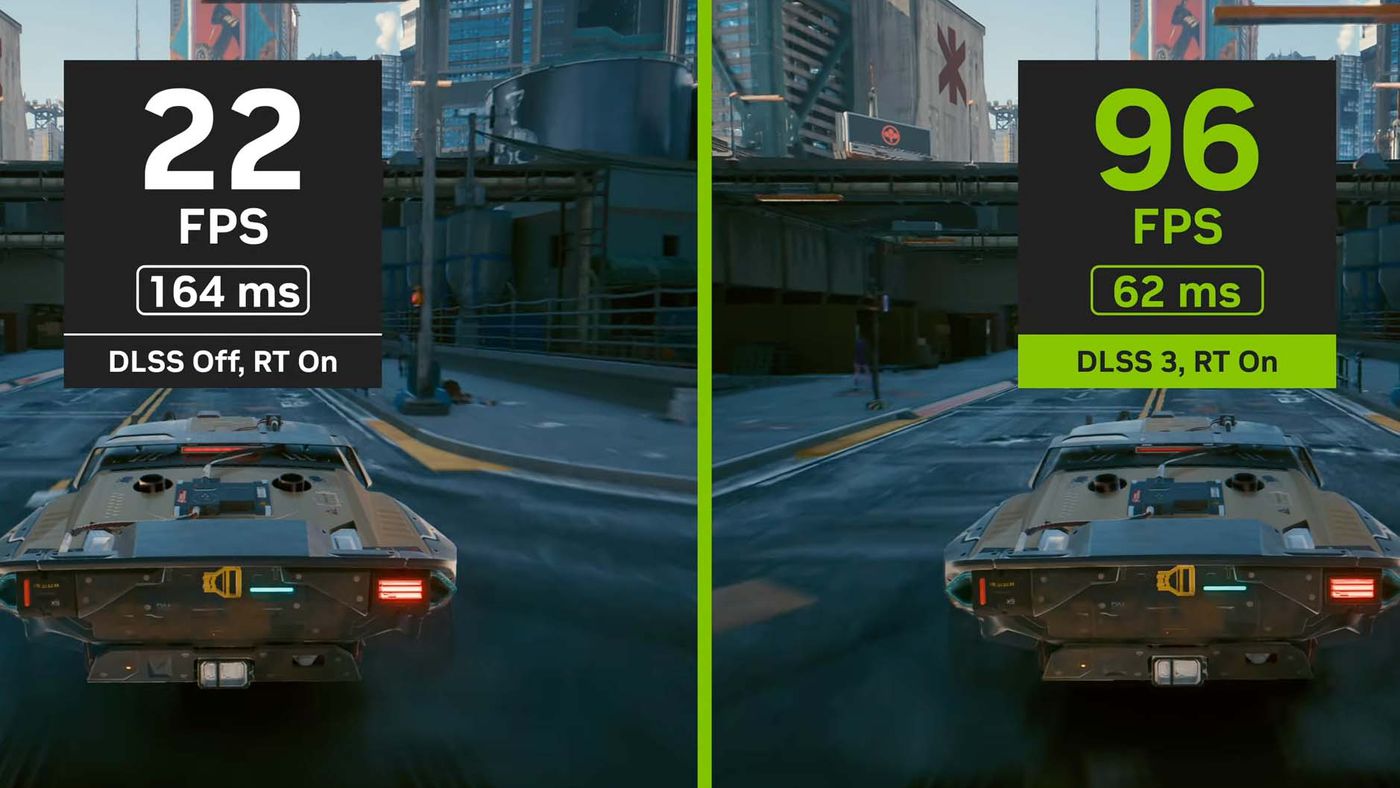

Pierwszymi kartami graficznymi obsługującymi tę technologię były modele z serii NVIDIA GeForce RTX 2000. Pomimo zastosowania oddzielnych rdzeni RT do pracy z oświetleniem, technologia okazała się zbyt zasobożerna, gdyż zwiększa obciążenie na GPU od jeden i pół do dwóch razy. Jednocześnie wyniki po 6 latach wyglądają niestale, gdyż za wdrożenie technologii odpowiada nie NVIDIA, a twórca gry. Okazuje się więc, że gry takie jak Minecraft, Quake 2 czy Control stają się piękniejsze na naszych oczach po włączeniu Ray tracingu, podczas gdy umowny Cyberpunk 2077 wygląda "tak sobie" i jednocześnie zaczyna przycinać się. Nie bez powodu filmy o tytułach w stylu „Ray Tracing Is Stupid” do dziś pojawiają się na YouTube.

Ale są też dobre wiadomości. Porozmawiajmy o nich w następnym akapicie.

DLSS to najfajniejszy bajer współczesnych kart graficznych

Być może najfajniejszym bajerem współczesnych kart graficznych jest technologia sztucznego skalowania NVIDIA Deep Learning Super Sampling (lub po prostu DLSS). Jest to tak zwany algorytm supersamplingu, który wykorzystując oddzielne rdzenie obliczeniowe karty graficznej skaluje rozdzielczość obrazu jak współczesne procesory telewizyjne, zwiększając płynność procesora. Przynajmniej tak działała pierwsza i druga wersja DLSS. Podczas premiery kart graficznych GeForce RTX 4000 „zieloni” zaprezentowali trzecią wersję DLSS z rewolucyjną technologią generowania klatek, która faktycznie dodaje FPS za pomocą AI. Jak wykazały testy, technologia ta może kilkakrotnie zwiększyć FPS (czasami o 2 – 4 razy), ale nie działa na kartach graficznych NVIDIA RTX 3000 i wcześniejszych seriach.

Radeon lekko odstaje w czasie, ale udostępnia technologię masom. Początkowo jego odpowiednik DLSS o nazwie FidelityFX Super Resolution (FSR) nie działał zbyt dobrze, ale wraz z pojawieniem się FSR drugiej generacji sytuacja zmieniła się diametralnie i dość trudno od razu dostrzec różnicę między DLSS 2 a FSR 2. FSR można uruchomić na niemal każdej karcie graficznej, łącznie ze starszymi RX 570 i GeForce GTX 1060. Wprowadzona w 2023 roku technologia FSR 3.0 również nauczyła się generować klatki, zwiększając kilkakrotnie liczbę FPS, ale na razie technologia ta jest prymitywna i wymaga czasu na udoskonalenie.

Ile pamięci wymagają współczesne gry?

Jeszcze kilka lat temu w klasie średniej królowały karty graficzne z 4 GB pamięci, a 8 czy 12 GB uważano za symbol bogactwa, sukcesu i witalności. Jednak wraz z pojawieniem się konsol nowej generacji i masowym rozpowszechnieniem silnika Unreal Engine 5 wielu programistów zaczęło orientować się na konsole PlayStation 5 i Xbox Series X wyposażonych w 12 GB pamięci VRAM, dekompresję sprzętową i przesyłanie strumieniowe z dysków SSD. Jak wyjaśnił jeden z czołowych twórców Unreal Engine 5, dla studiów gier przestawienie się po PS5 na 8 GB VRAM dla zoptymalizowania obrazu na PC bez widocznej utraty jakości będzie po prostu nieopłacalne. Dlatego nawet jeśli nie planujesz znacząco zwiększać rozdzielczości, korzystać z ray tracingu i grać wyłącznie na „ultra”, najbardziej rozsądną i optymalną opcją z rezerwą na przyszłość będzie karta graficzna z 12 lub nawet 16 GB pamięci VRAM. Niedawno opublikowaliśmy materiał na ten temat.

Wymiary i TDP

Wybierając kartę graficzną, należy zestawić wymiary obudowy, maksymalna długość karty graficznej jest zawsze podawana w specyfikacji obudowy. Jeśli szczelina między obudową a krawędziami karty graficznej wynosi zaledwie kilka centymetrów, proces montażu może być utrudniony. A sama karta graficzna będzie miała słabą wentylację.

Ta sama porada dotyczy zużycia energii. Każdy konkretny model pobiera określoną ilość energii, a żeby użytkownik nie musiał obliczać potrzebny TDP dla całego systemu, większość producentów podaje w specyfikacji zalecaną moc zasilacza. Należy przestrzegać tych zaleceń, ponieważ ta wartość jest obliczana z zapasem, aby zasilacz nie musiał pracować na granicy swoich możliwości.

Podsumowanie

Wybierając kartę graficzną do gier lub pracy, ważne jest, aby znaleźć równowagę pomiędzy jej wydajnością a kosztem pozostałych komponentów. Fizyki nikt nie anulował, o mocy obwodu decyduje jego najsłabsze ogniwo, więc zakup GeForce RTX 4090 do 6-rdzeniowego Core i5 dosłownie ma tyle samo sensu, co w nowych sezonach The Walking Dead. Ogólnie rzecz biorąc, wybierając kartę graficzną, należy wziąć pod uwagę nie tylko jej cenę, rok produkcji i ogólny poziom wydajności, ale także takie czynniki, jak zużycie energii i kompatybilność z obudową. Należy także uwzględnić aktualne warunki rynkowe – ceny starszych GPU mogą spaść po zapowiedzi nowych linii.

Aby uzyskać jak najbardziej aktualne informacje i porady, zalecamy zapoznanie się z recenzjami na specjalistycznych portalach lub w grupach w sieciach społecznościowych. Na przykład w e-katalogu regularnie zamieszczamy materiały z optymalnymi zestawami komputerowymi na każdą kieszeń, a także recenzje na najbardziej udane modele i topowe w swoim przedziale cenowym GPU. Filtrowanie według ceny i popularności w kategorii kart graficznych może być bardzo przydatnym narzędziem.

Artykuły, recenzje, przydatne porady

Wszystkie materiały