Wszystkie szczegóły dotyczące nowych kart graficznych GeForce RTX 4080 i 4090 opartych na architekturze Ada Lovelace

Dowiedz się więcej o architekturze Ada Lovelace i DLSS 3.0

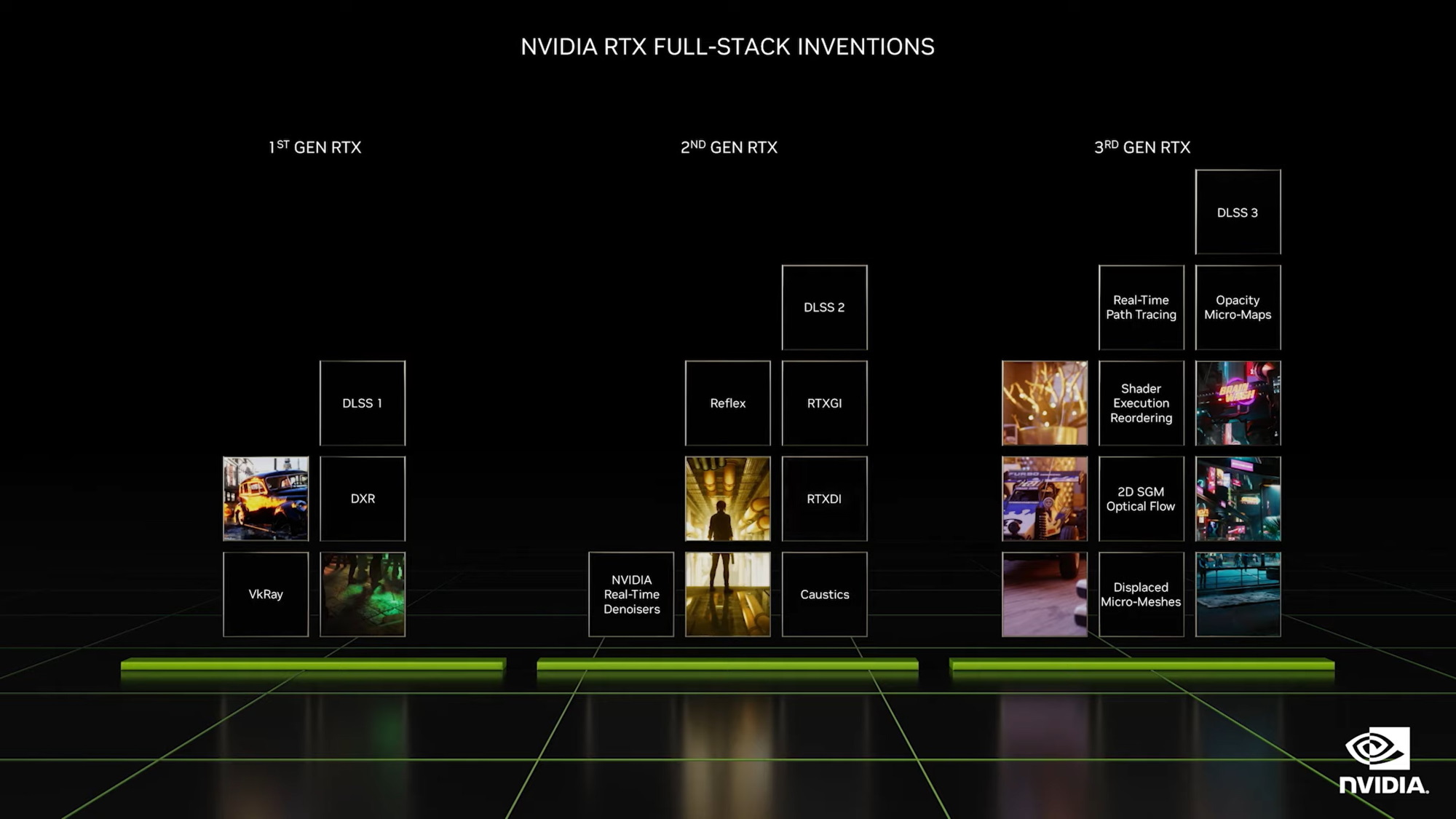

Poprzednia generacja, zwana Ampere, przez wielu słusznie była nazywana rewolucją. NVIDIA była jedną z pierwszych, która powiązała sieci neuronowe i algorytmy uczenia maszynowego ze swoim sprzętem, a wynikiem tych eksperymentów była szykowna rzecz o nazwie Deep Learning Super Sampling (lub po prostu DLSS). Jest to tzw. algorytm supersamplingu, który upskaluje obraz w stylu nowoczesnych procesorów telewizyjnych, jednocześnie zwiększa liczbę klatek na sekundę oraz zwiększa klarowność i rozdzielczość obrazu. Podczas opracowywania Ady Lovelace inżynierowie NVIDIA skupili się na dopracowaniu istniejących technologii.

W szczególności, trzecia wersja DLSS została zaprezentowana z wbudowanym optymalizatorem NVIDIA Reflex, który według przedstawicieli NVIDII może sztucznie zwiększyć liczbę klatek 2-4 (!) razy. W przeciwieństwie do starszych wersji, DLSS 3.0 nie tylko rysuje piksele w istniejących klatkach, ale także niezależnie generuje całe klatki pośrednie. W tym celu DLSS nauczono pracować z czterema typami danych (ramki, przepływ optyczny, wektory ruchu i głębokość), co zwiększyło dokładność i wydajność silnika. Następnie algorytm wbudowany w DLSS 3 analizuje wszystkie cztery typy danych i wybiera najbardziej odpowiednie dla każdej konkretnej ramki.

|

| Wydajność DLSS 3.0 w grach. |

Należy zauważyć, że pole przepływu optycznego to zupełnie nowa koncepcja w dziedzinie skalowania, za którą odpowiada osobny akcelerator sprzętowy. Jego istota sprowadza się do odnalezienia i zidentyfikowania powiązań pomiędzy ruchami pikseli i obiektów w kolejnych klatkach. Skorelowanie tych danych z danymi dotyczącymi ruchu i dynamiki pozwoli na dokładniejsze odtworzenie zmian w geometrii sceny. Właśnie z powodu tej funkcji obsługa DLSS została dodana tylko do nowych kart graficznych. Według przedstawicieli NVIDII gracze z kartami RTX 30XX podczas beta testów regularnie napotykali lagi i artefakty podczas aktywacji DLSS 3.0, dlatego zdecydowali się usunąć tę opcję. Przez chwilę lub na zawsze nawet nVIDIA jeszcze nie wie.

Działanie DLSS 3.0 zostało zademonstrowane na przykładzie Cyberpunk 2077 i Microsoft Flight Simulator. W pierwszym przypadku liczba klatek na sekundę została zwiększona 4-krotnie, w drugim - o 2. Wynika to z faktu, że wydajność Flight Simulatora jest silnie uzależniona od procesora. Ale co jest ogólnie niezrozumiałe, dlaczego Cyberpunk 2077 produkuje 22 FPS na flagowej karcie graficznej 2022? Istnieje podejrzenie, że nVIDIA włączyła tryb raytracingu opóźnionego overdrive, aby porównania wyglądały bardziej imponująco.

Podczas zapowiedzi nowej generacji chłopaki z NVIDII postanowili trochę oszukać, wykorzystując swoje doświadczenie w tworzeniu mobilnych kart graficznych. Dlatego kilka ważnych szczegółów technicznych trafiło do prasy dopiero dzień po ogłoszeniu. Początkowo było wiadomo, że flagowy RTX 4090 bazuje na układzie graficznym AD102. I to było założenie, że obie wersje RTX 4080 bazują na tym samym GPU, prawda? Więc dobrze?

Jak się okazało, nie. Podążamy za naszymi rękami. Wersja RTX 4080 12 GB zawiera 7680 rdzeni CUDA i 192-bitową magistralę. Z kolei RTX 4080 16GB ma na pokładzie 9728 rdzeni CUDA, a szerokość magistrali została zwiększona do 256-bitów. Oznacza to, że są to niejako różne karty wideo o tym samym nazwisku. A jeśli zajrzysz pod maskę, są oparte na różnych procesorach graficznych. Wersja 16 GB bazuje na układzie AD103, natomiast wersja 12 GB na układzie GA104 poprzedniej generacji, który zastosowano w RTX 3070.

Aby ukryć oszustwo, nVIDIA nieco podniosła taktowanie 12-gigabajtowej wersji, by wyglądała korzystniej na tle swojego starszego brata. Tak więc w trybie normalnym działa na częstotliwości 2,31 GHz, a w razie potrzeby może automatycznie przetaktować do 2,61 GHz. Dla porównania, RTX 4080 16 GB działa na częstotliwościach od 2,21 do 2,51 GHz, ale ma szerszy inny rdzeń, szerszą magistralę i więcej rdzeni CUDA, więc wydajność jest wyższa. Ale jeśli tego nie wiesz i jesteś przyzwyczajony do patrzenia tylko na częstotliwości, może się wydawać, że młodszy model jest jeszcze mocniejszy. Chociaż w rzeczywistości bardziej uczciwe jest nazywanie wersji 12 GB RTX 4070 i nie obłudnie, trudno byłoby ją sprzedać za 900 USD, jeśli tak jest.

RTX 4080 z 16 GB VRAM należy do średniego poziomu, pod wieloma względami omijając młodszą wersję RTX 4080 z 12 GB, ale jednocześnie znacznie ustępuje flagowemu RTX 3090 z 24 GB G6X VRAM. Podczas produkcji inżynierowie NVIDIA wykorzystali nowe multiprocesory strumieniowe i rdzenie tensorowe czwartej generacji, co podwoiło wydajność wbudowanych algorytmów supersamplingu.

Pomimo nowej architektury (Ada Lovelace, proces produkcyjny TSMC 5 nm), pod względem wzornictwa, RTX 4080 w dużej mierze powtarza swojego poprzednika, RTX 3080. Przewiduje on osobne rdzenie RT trzeciej generacji. Wykorzystuje jednak zupełnie nową kość AD103 z 9728 rdzeniami CUDA, buforem GDDR6X i przepustowością 720 GB/s jako podstawą. Zgodnie z oświadczeniem, cała ta dobroć okazuje się 2-3 razy szybsza od poprzednika RTX 3080 Ti. Zalecany koszt modelu to 1199 USD.

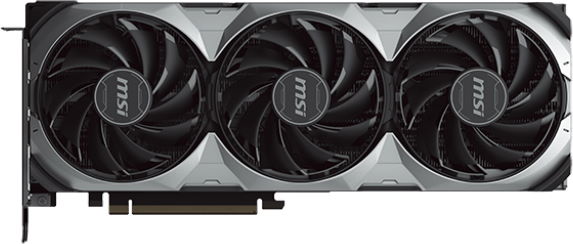

Wersja RTX 4080 16GB firmy MSI technicznie odpowiada próbce referencyjnej, ale wszystko inne zostało przerobione. W szczególności standardowy układ chłodzenia został zastąpiony radiatorem z trzema wentylatorami Torx czwartej generacji, konstrukcja została wzmocniona metalowymi backplates, a całe oświetlenie zostało umieszczone pod nożem, aby nie mylić graczy z metkami.

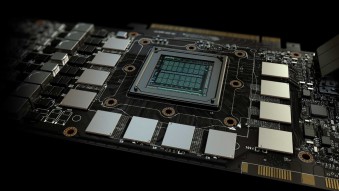

RTX 4090 to flagowa karta graficzna, która zapewnia niesamowitą wydajność według standardów 2022. Wykorzystuje nową matrycę AD102 z 16 384 rdzeniami CUDA i obsługą 384-bitowej magistrali pamięci. Objętość bufora wideo sięga imponujących 24 GB pamięci GDDR6X o przepustowości 1008 GB/s.

W jej produkcji zastosowano nowe multiprocesory strumieniowe, rdzenie tensorowe czwartej generacji oraz rdzenie RT klasy 3.0, dzięki czemu znacząco wzrosła wydajność ray tracingu i sztucznego skalowania obrazu. Moc obliczeniowa tego kolosa sięga 83 Tflops, a przewaga w wydajności w grach nad kartami poprzedniej generacji może być czterokrotna.

Podczas zapowiedzi Jensen Huang podkreślił, że jest to idealna karta nie tylko dla graczy, ale także dla twórców treści. Dlatego RTX 4080 oferuje kodery NVIDIA, obsługę aplikacji NVIDIA Broadcast oraz integrację z platformą graficzną NVIDIA Studio. Ponadto w sterownikach karty graficznej wszyto obsługę zintegrowanej technologii NVIDIA Reflex w celu zmniejszenia opóźnienia wejścia. Wszystko to zaowocowało dość wysoką sugerowaną ceną - 1599 USD.

W przypadku modyfikacji GAMING TRIO inżynierowie MSI przeprojektowali obudowę i system chłodzenia, dodając do projektu masywną metalową płytę tylną i trzy markowe wentylatory TORX piątej generacji. Ponadto karta graficzna została ozdobiona diodami LED z obsługą systemu MSI Mystic Light oraz podwójnym BIOS-em do szybkiego przełączania między ustawieniami.

Wydajność w grach

|

| Porównanie wydajności z poprzednią generacją kart graficznych NVIDIA. |

Wydajność w grach nowych produktów jest zdecydowanie imponująca, ale jak na razie nie ma uczciwych testów, a jedynie oficjalne informacje, lepiej brać to z przymrużeniem oka. W szczególności w komentarzach pod jednym z dem Cyberpunka ludzie dosłownie rażą się faktem, że NVDIA celowo wprowadza niepotrzebne ustawienia graficzne, takie jak RT Override, aby celowo zmniejszyć liczbę klatek na sekundę, a następnie sztucznie ją zwiększyć za pomocą DLSS 3.0 i z dumą deklarują: że „Karty RTX 40XX są 4 razy mocniejsze niż ich poprzednicy, biegnij do sklepu. Przepraszam za narzekanie.

Według wstępnych danych, RTX 4090 działa od 1,5 do 2 razy lepiej niż RTX 3090 Ti. Testy przeprowadzono w Assassin's Creed Valhalla, Resident Evil Village oraz Microsoft Flight Simulator. W grach nowej generacji skupiających się na oświetleniu i ray tracingu, RTX 4090 ma prawie czterokrotną przewagę nad RTX 3090 Ti. Czy jest to związane z DLSS 3.0, czy nie, NVIDIA nie sprecyzowała.

RTX 4080 z 16 GB w grach starej generacji bez ray tracingu przewyższa RTX 3090 Ti średnio półtora raza. Przy włączonym ray tracingu i DLSS różnica wydajności może być dwu- lub trzykrotna. Poważny wynik. Tak naprawdę prawdziwą alternatywą dla starego RTX 3090 Ti jest młodszy model GeForce RTX 4080 z 12 GB pamięci wideo. W normalnych testach idą łeb w łeb, a różnica w FPS rzadko przekracza 10 klatek. Po aktywacji ray tracingu i DLSS 3.0 nowość włącza dopalacz i jest przenoszona do przodu z dwukrotnie większą prędkością.

Inne szczegóły techniczne

|

| Ewolucja kart graficznych RTX. |

Po opublikowaniu wszystkich specyfikacji technicznych na stronie NVIDII okazało się, że nowe produkty będą kompatybilne ze starymi zasilaczami. Według wstępnych przecieków kolejna generacja RTX miała przejść na nowy format zasilacza ze złączem PCI-E piątej generacji. W rzeczywistości okazało się, że RTX 4090 i RTX 4080 są zaprojektowane do korzystania zarówno ze starych 8-pinowych złączy, jak i nowych złączy PCI-E 5.

Zużycie energii przez karty wzrosło, ale nie tak bardzo, jak obawiali się wtajemniczeni. Według oficjalnych danych, flagowy RTX 4090 z 24 GB VRAM pobiera 450 W (uwaga: zasilacz 850 W jest zalecany dla całego systemu), podczas gdy RTX 4080 wymaga od 285 do 320 W (w zależności od ilości VRAM). . I to dobra wiadomość, ponieważ karty graficzne RTX 30XX zużywały prawie taką samą ilość energii, więc większość ludzi nie będzie musiała zawracać sobie głowy aktualizacją zasilacza. NVIDIA wspomniała również, że nie wyklucza pojawienia się specjalnych wersji podkręcania o poborze mocy poniżej 600 W, ale jeśli tak się stanie, to będzie to kawałkowy produkt dla entuzjastów.

Wszystkie nowe urządzenia są wyposażone w nowoczesne porty HDMI 2.1a, dzięki czemu mogą przesyłać wideo HDR w rozdzielczości 4K z częstotliwością odświeżania 120 Hz, co w pełni spełnia wymagania gier nowej generacji. Ale interfejsu DisplayPort 2.0 obiecanego przez wtajemniczonych nie było tutaj, zamiast tego używana jest wersja DP 1.4a.

Posłowie

|

| Ten sam projekt, co poprzednia generacja. |

NVIDIA po raz kolejny ma linię zaawansowanych technicznie kart graficznych z poważną wydajnością i kilkoma dodatkowymi gadżetami na pokładzie (DLSS, Ray Tracing, Reflex itp.). A konkurenci znów będą musieli kopiować, upraszczać i nadrabiać zaległości. Problem polega na tym, że nVIDIA zbyt długo siedzi na tronie, trochę się spiąła i, sądząc po cenach, w końcu straciła kontakt z graczami. Komentarze pod newsami i pierwsze recenzje są dosłownie zalane nienawiścią ze strony byłych fanów marki, którzy szczerze nie rozumieją, jak konsumencka, choć bardzo potężna, karta graficzna może kosztować prawie 2000 dolarów, choć nawet w czasach przedsowieckich można było zmontować poważny komputer do gier za te pieniądze, tak, trochę więcej zostałoby na monitorze.

Artykuły, recenzje, przydatne porady

Wszystkie materiały