Всі подробиці про нові відеокарти GeForce RTX 4080 та 4090 на архітектурі Ada Lovelace

Докладніше про архітектуру Ada Lovelace та DLSS 3.0

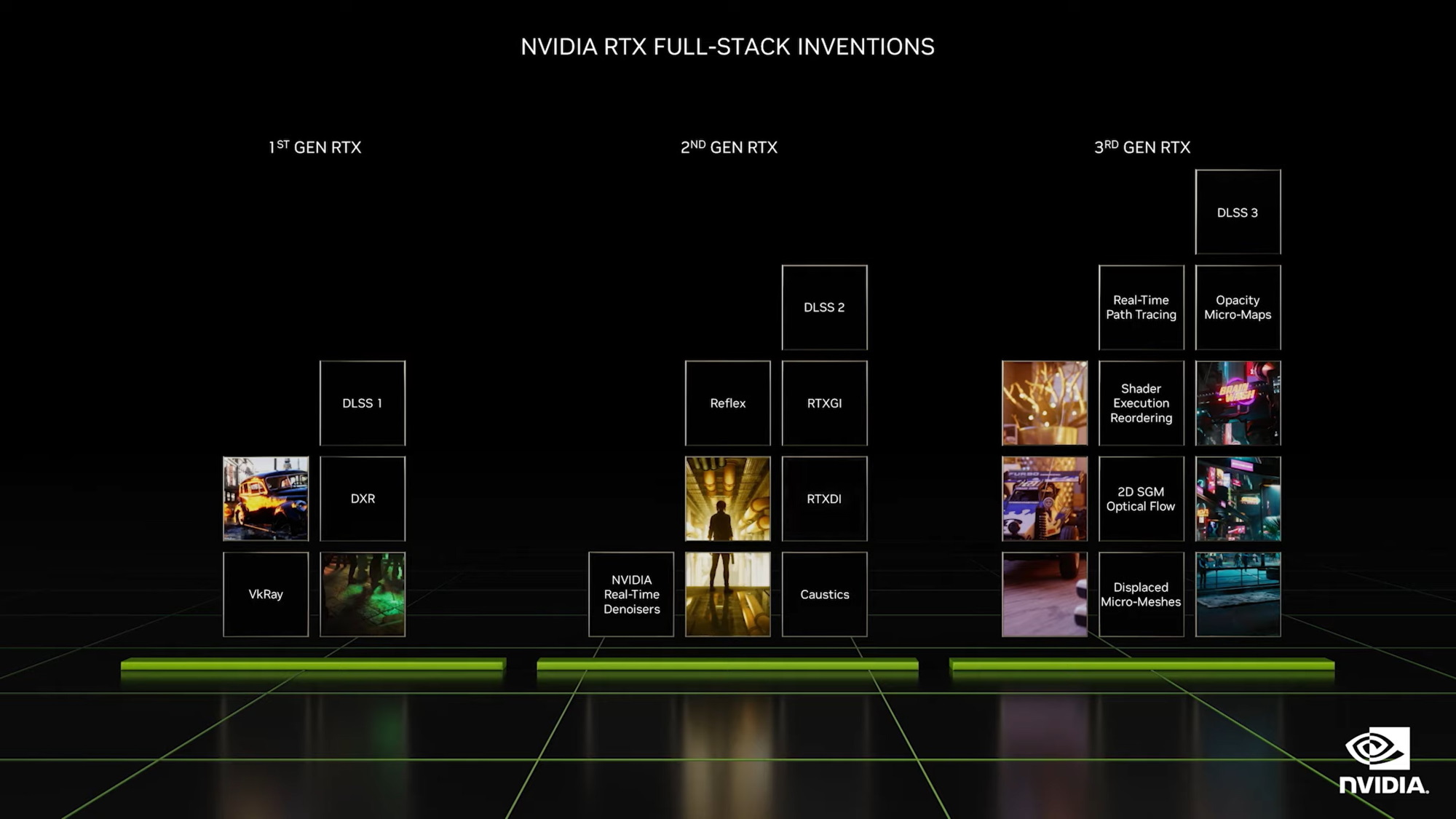

Попереднє покоління під назвою Ampere багато хто справедливо називав революцією. NVIDIA однією з перших стала підв'язувати до свого заліза нейромережі та алгоритми машинного навчання, а результатом цих експериментів стала шикарна штука під назвою Deep Learning Super Sampling (або просто DLSS). Це так званий алгоритм суперсемплювання, який апскейліт зображення в стилі сучасних ТВ-процесорів, одночасно збільшує кількість FPS і підвищує чіткість та роздільну здатність картинки. Під час розробки Ada Lovelace інженери NVIDIA зосередилися на доопрацюванні наявних технологій.

Зокрема було представлено третю версію DLSS із вбудованим оптимайзером NVIDIA Reflex, яка, за словами представників NVIDIA, способу штучно підняти частоту кадрів у 2 – 4 (!) рази. На відміну від старих версія, DLSS 3.0 не просто малює пікселі в кадрах, що вже є, але і самостійно генерує цілі проміжні кадри. Для цього DLSS навчили працювати з чотирма типами даних (кадри, оптичний потік, вектори руху та глибини), завдяки чому зросла точність та ефективність двигуна. Потім вбудований у DLSS 3 алгоритм аналізує дані всіх чотирьох типів і вибирає найпридатніші для кожного конкретного кадру.

|

Потрібно зазначити, що поле оптичного потоку — це абсолютно новий концепт у сфері масштабування, за який відповідає окремий апаратний прискорювач. Його суть зводиться до пошуку та виявлення зв'язків між переміщеннями пікселів та об'єктів у наступних кадрах. Зіставлення цих даних з даними про рух та динаміку дозволить більш точно відтворювати зміни у геометрії сцени. Саме через цю фічу підтримку DLSS додали лише новим відеокартам. За словами представників NVIDIA, геймери з картками RTX 30XX під час бета-тестів регулярно стикалися з лагами та артефактами під час активації DLSS 3.0, тому цю опцію вирішили прибрати. Чи на якийсь час чи назавжди ― поки що не знають навіть у NVIDIA.

Роботу DLSS 3.0 продемонстрували на прикладі Cyberpunk 2077 та Microsoft Flight Simulator. У першому випадку частоту кадрів вдалося підвищити вчетверо, у другому — вдвічі. Пов'язано це з тим, що продуктивність Flight Simulator сильно залежить від процесора. А ось що взагалі незрозуміло, чому на флагманській відеокарті 2022 Cyberpunk 2077 видає 22 FPS? Є підозра, що в NVIDIA включили лагающий overdrive raytracing mode, щоб порівняння виглядало ефектніше.

Під час анонсу нового покоління хлопці з NVIDIA вирішили трохи схитрувати, скориставшись своїм досвідом розробки мобільних відеокарт. Тому деякі важливі технічні деталі потрапили в пресу лише за добу після анонсу. Спочатку було відомо, що флагманська RTX 4090 побудована на базі графічного чипа AD102. І з цього випливало припущення, що обидві версії RTX 4080 засновані на тому ж GPU, чи не так? Адже так?

Як виявилось, ні. Слідкуємо за руками. Версія RTX 4080 12GB включає 7680 ядер CUDA, розрядність шини становить 192-біта. У свою чергу, RTX 4080 16GB несе на борту 9728 CUDA-ядер, а розрядність шини підвищена до 256-біт. Тобто за фактом це різні відеокарти з однаковим прізвищем. І якщо заглянути під капот, то вони засновані на різних GPU. Версія на 16 ГБ побудована на чіпі AD103, а 12-гігабайтна варіація базується на чіпі минулого покоління GA104, який використовувався у RTX 3070.

З метою приховування мухлежа, NVIDIA злегка задерли тактові частоти 12-гігабайтної версії, щоб вона виглядала вигідніше на тлі старшого брата. Так у штатному режимі вона працює на частоті 2.31 ГГц, а за потреби може автоматично розганятися до 2.61 ГГц. Для порівняння RTX 4080 16 GB оперує на частотах в діапазоні від 2.21 до 2.51 ГГц, але у неї ширше інше ядро, ширша шина і більше CUDA-ядер, тому і продуктивність вище. Але якщо цього не знати і звично дивитися лише на частоти, то може здатися, що молодша модель навіть потужніша. Хоча насправді версію на 12 ГБ чесніше було б назвати RTX 4070 і не лукавити, але в такому разі її складно було б продавати за 900 доларів.

RTX 4080 c 16 ГБ відеопам'яті відноситься до середнього рівня, багато в чому обходячи молодшу версію RTX 4080 c 12 ГБ, але при цьому суттєво поступаючись флагманською RTX 3090 з 24 ГБ відеопам'яті G6X. При виробництві інженери NVIDIA використовували нові потокові мультипроцесори та тензорні ядра четвертого покоління, завдяки яким удвічі зросла ефективність вбудованих алгоритмів суперсемплінгу.

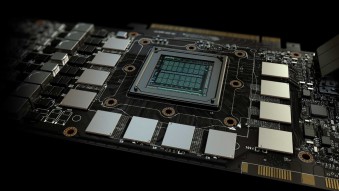

Незважаючи на нову архітектуру (Ada Lovelace, техпроцес TSMC 5 нм) з точки зору дизайну RTX 4080 багато в чому повторює попередника в особі RTX 3080. Масивну друковану плату накриває комплексна система охолодження, сама картка займає кілька слотів материнської плати, а для обробки освітлення у ній передбачені окремі RT-ядра третього покоління. А ось як основа використовується абсолютно новий кристал AD103 з 9728 ядрами CUDA, буфером GDDR6X і пропускною здатністю на рівні 720 Гбайт/с. За заявою все це добро виявляється у 2 – 3 рази швидше за попередника RTX 3080 Ti. Рекомендована вартість моделі складає $1199.

Версія RTX 4080 16GB у виконанні MSI у технічному плані відповідає референсному зразку, а ось інше переробили. Зокрема штатну систему охолодження замінили радіатором із трьома вентиляторами Torx Fan четвертого покоління, конструкцію підсилили металевими бекплейтами, а все підсвічування відправили під ніж, щоб не бентежити геймерів цінниками.

RTX 4090 ― це флагманська відеокарта з неймовірною продуктивністю за мірками 2022 року. У ній використовує новий кристал AD102 з 16384 ядрами CUDA, і підтримкою 384-розрядної шиною пам'яті. Об'єм відеобуфера досягає значних 24 ГБ пам'яті GDDR6X з пропускною здатністю 1008 Гбайт/с.

При її виробництві були використані нові потокові мультипроцесори, тензорні ядра четвертого покоління та RT-ядра класу 3.0, завдяки яким суттєво зросла ефективність трасування променів та штучного масштабування зображення. Обчислювальна потужність цієї махини досягає 83 Тфлопс, а перевага в ігровій продуктивності над картами минулого покоління може бути чотириразовою.

Під час анонсу Дженсен Хуанг наголосив на тому, що це ідеальна картка не тільки для геймерів, але і для творців контенту. Тому RTX 4080 може похвалитися наявністю енкодерів NVIDIA, підтримкою програми NVIDIA Broadcast та інтеграцією з графічною платформою NVIDIA Studio. Також драйвери відеокарти вшили підтримку комплексної технології NVIDIA Reflex для зниження затримки введення. Все це вилилося в досить високу рекомендовану ціну $1599.

Для модифікації GAMING TRIO інженери MSI переробили кожух і систему охолодження, додавши в конструкцію масивний металевий бекплейт і три фірмові вентилятори TORX Fan п'ятого покоління. Додатково відеокарту прикрасили світлодіодами із підтримкою системи MSI Mystic Light та подвійним BIOS для швидкого перемикання між налаштуваннями.

Продуктивність у іграх

|

Ігрова продуктивність новинок безперечно вражає, але поки що немає чесних тестів, а лише офіційна інформація, сприймати її краще з часткою скептицизму. Зокрема, в коментарях під одним із демо-роликів Cyberpunk у людей буквально палахкотить від того, що в NVDIA навмисно включають непотрібні графічні налаштування типу RT Override, щоб має намір знизити частоту кадрів, а потім штучно підвищити її за допомогою DLSS 3.0 і гордо заявити, що «картки RTX 40XX в 4 рази потужніші за попередників, бігом до магазину. Вибачте за буркотіння.

Згідно з попередніми даними, RTX 4090 показує результати в 1.5 – 2 рази вище, ніж RTX 3090 Ti. Тести проводилися в Assassin's Creed Valhalla, Resident Evil Village та Microsoft Flight Simulator. У некстген іграх з акцентом на освітленні та трасуванні променів RTX 4090 має майже чотириразову перевагу над RTX 3090 Ti. Чи пов'язано це з DLSS 3.0 чи ні NVIDIA не уточнили.

RTX 4080 з 16 ГБ в іграх старого покоління без рейтрейсингу випереджає RTX 3090 Ti в середньому в півтора рази. З увімкненим рейтрейсингом та DLSS різниця у продуктивності може бути двох або триразовою. Серйозний результат. По суті, справжньою альтернативою старенькому RTX 3090 Ti є молодша модель GeForce RTX 4080 з 12 ГБ відеопам'яті. У звичайних тестах вони йдуть ніздрі в ніздрю, а різниця у FPS рідко перевищує 10 кадрів. При активації рейтрейсингу та DLSS 3.0 новинка включає форсаж і виноситься вперед на вдвічі більшу швидкість.

Інші технічні нюанси

|

Після публікації всіх технічних характеристик на сайті NVIDIA виявилося, що новинки сумісні зі старими блоками живлення. Згідно з попередніми зливами, наступне покоління RTX мало перейти на блоки живлення нового формату з роз'ємом PCI-E п'ятого покоління. Насправді виявилося, що RTX 4090 та RTX 4080 розраховані і на використання старих 8-пінових роз'ємів, і на нові роз'єми PCI-E 5.

Енергоспоживання карток зросло, але далеко не так сильно, як лякали інсайдери. Згідно з офіційними даними, флагманська RTX 4090 з 24 ГБ відеопам'яті споживає 450 Вт (прим: для всієї системи рекомендується БЖ на 850 Вт), в той час як RTX 4080 потрібно від 285 до 320 Вт (залежить від об'єму відеопам'яті). І це хороші новини, адже відеокарти RTX 30XX споживали практично таку ж кількість енергії, тому більшості людей не доведеться морочитися з апгрейдом блоку живлення. Також у NVIDIA згадали, що не виключають появу спеціальних розгінних версій з енергоспоживанням під 600 Вт, проте якщо це станеться, це буде штучна продукція для ентузіастів.

Всі новинки оснащені сучасними портами HDMI 2.1a і тому здатні на передачу HDR-відео з роздільною здатністю 4K з частотою оновлення 120 Гц, що повністю відповідає вимогам некстген ігор. А ось обіцяного інсайдерами інтерфейсу DisplayPort 2.0 тут не виявилося, натомість використовується версія DP 1.4a.

Післямова

|

NVIDIA в черговий раз вийшла лінійка технічно просунутих відеокарт з серйозною продуктивністю і купою додаткових плюшок на борту (DLSS, Ray Tracing, Reflex і т.д.). А конкурентам вкотре доведеться копіювати, спрощувати та наздоганяти. Проблема в тому, що NVIDIA занадто довго сидить на троні, трохи забронзовіла і, судячи з цін, остаточно втратила зв'язок з гравцями. Коментарі під новинами та першими оглядами буквально завалені хейтом від колишніх шанувальників бренду, які щиро не розуміють, як споживча, нехай і дуже потужна відеокарта може коштувати майже 2 тисячі доларів, хоча ще в доковидні часи за ці гроші можна було зібрати серйозний ігровий ПК, та ще трохи лишилося б на монітор.

Статті, огляди, корисні поради

Усі матеріали