Jak określić odwzorowanie kolorów monitora według cech?

Zależność odwzorowania kolorów od rodzaju matrycy

|

Wszelkie rozmowy na temat zdolności monitora do dokładnego wyświetlania kolorów należy zaczynać od typów matryc.

Większość macierzy TN nie radzi sobie z wyświetlaniem kolorów. Ich mocną stroną jest szybka reakcja i niski koszt.

Ekrany VA można postawić na wycięcie, ale ich wierność kolorów też nie jest idealna. Jednak ostatnio na rynku coraz częściej pojawiają się monitory VA dla projektantów z dobrymi kątami widzenia, naturalnym odwzorowaniem kolorów i cenami nieco niższymi niż IPS.

IPS jest pod tym względem najlepszy: oferują nie tylko dokładne odwzorowanie kolorów, ale także szeroki zakres dynamiki połączony z optymalną jasnością i kontrastem. To wszystko to również ważne parametry, które wpływają na postrzeganie koloru. Dlatego projektanci wolą pracować na monitorach IPS.

PLS to „zaawansowana” odmiana IPS, którą rozwija Samsung. Tak naprawdę nie ma przekonujących dowodów na przewagę PLS nad IPS i niestety nie widzieliśmy dwóch w 100% identycznych monitorów z takimi matrycami do bezpośredniego porównania.

Głębia kolorów i głębia bitowa monitora

|

Większość przeciętnych monitorów, które mamy w domu lub w pracy korzysta z klasycznej 8-bitowej matrycy.

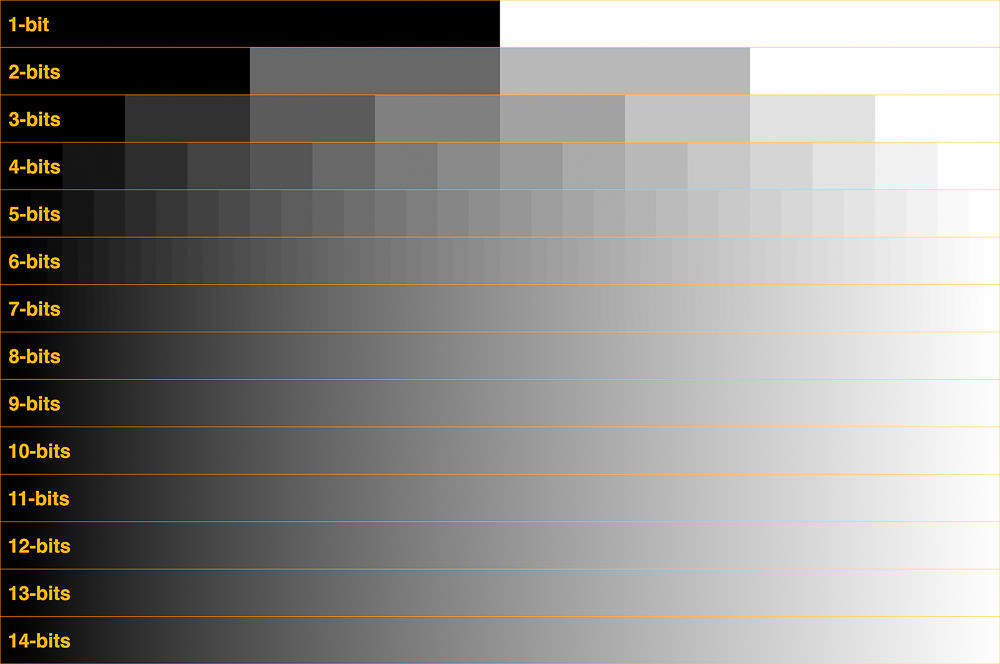

Najpierw spójrzmy na bity. Bit to kawałek kodu binarnego, który może przyjmować jedną z dwóch wartości, 1 lub 0, tak lub nie. Mówiąc o monitorach i pikselach, gdyby to był piksel, byłby całkowicie czarny lub całkowicie biały. Nie jest to najbardziej przydatna informacja do opisania złożonego koloru, więc możemy połączyć kilka bitów. Za każdym razem, gdy dodajemy bity, liczba potencjalnych kombinacji podwaja się. Jeden bit ma 2 możliwe wartości, właściwie zero i jeden. W dwóch bitach możemy już zmieścić cztery możliwe wartości - 00, 01, 10 lub 11. W trzech bitach liczba opcji rośnie do ośmiu. Itp. Całkowita liczba opcji jest równa dwóm podniesionym do potęgi liczby bitów.

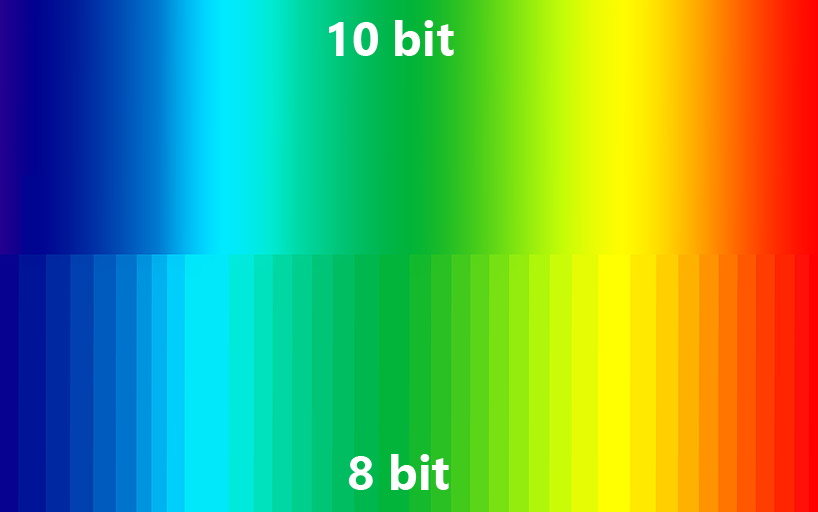

W rzeczywistości „głębokość bitowa” określa wielkość zmiany odcienia, jaką może wyświetlić monitor. Z grubsza mówiąc, metaforyczny monitor z dwubitowym kolorem może wyświetlać tylko 4 odcienie podstawowych kolorów: czarny, ciemnoszary, jasnoszary i biały. Oznacza to, że może pokazać kolorowe obrazy impresjonistów tylko w trybie „odcieni brudu w kałuży”. Klasyczna 8-bitowa matryca wyświetla 16,7 miliona odcieni, podczas gdy profesjonalna 10 -bitowa matryca wytwarza ponad miliard odcieni, zapewniając maksymalną dokładność i szczegółowość w palecie kolorów.

W ten sposób gradient od czerni do bieli będzie wyglądał na różnych głębokościach bitowych |

Co to są macierze FRC i pseudo 8 i 10 bitowe?

|

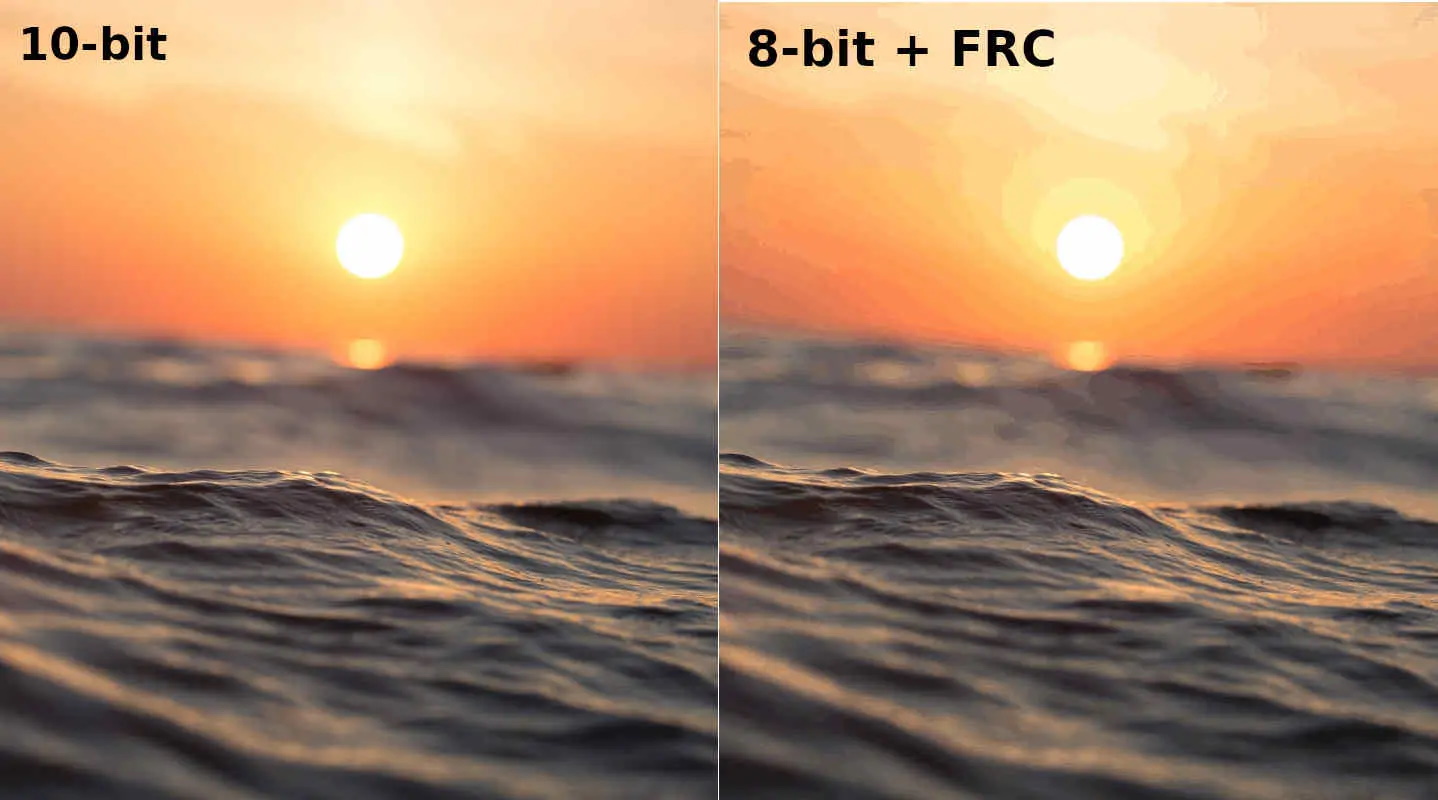

Świetnie, w pewnym sensie odkryliśmy bitowość, ale czym jest FRC? W danych paszportowych monitorów często znajduje się charakterystyka w duchu 6 bitów + FRC lub 8 bitów + FRC. Jest to sztuczka, która pozwala uzyskać większą głębię kolorów na wyświetlaczach LCD bez zwiększania głębi bitowej. Pozwala zwiększyć liczbę wyświetlanych odcieni poprzez zmianę jasności subpiksela klatka po klatce, dzięki czemu oko odbierze ten sam kolor, co cała paleta jego odcieni. Takie sztuczki pozwalają monitorowi wyświetlić brakujące kolory przy użyciu dostępnej palety, a konwencjonalna 8-bitowa matryca może wyświetlić cały miliard kolorów, charakterystycznych dla 10 bitów, zamiast zwykłych 16 milionów.

Jeśli przełożymy tę rozmowę na płaszczyznę „więc co wziąć?”, to radzimy nie oszczędzać na macierzach 6bit + frc, ponieważ kosztują plus lub minus, tak jak zwykłe monitory 8-bitowe. Jeśli nie jesteś estetą i nie masz orlej wizji, to taka matryca wystarczy do codziennej pracy, gier i multimediów. Cóż, zaleca się rozwidlenie dla wyświetlaczy 10-bitowych, jeśli:

- Czy jesteś projektantem/artystą?

- Czy jesteś graczem o wysokich wymaganiach sprzętowych?

- masz dodatkowe pieniądze

Ile bitów potrzebuje monitor?

|

Jak pokazuje praktyka, nie każde ludzkie oko widzi różnicę między matrycą 8-bitową a 10-bitową. Zwłaszcza jeśli na ekranie dzieje się coś dynamicznego, na przykład kilkanaście sportowych samochodów pomalowanych w barwy drużyny pędzi po zalanym słońcem torze. Przed pojawieniem się formatu HDR obrazy 8-bitowe uważano za standard, ten format był używany w odtwarzaczach Blu-ray, monitorach gier oraz zwykłych monitorach biurowych lub domowych.

Jednak nowoczesne panele, zwłaszcza popularne obecnie telewizory OLED, są w stanie wyświetlić znacznie więcej odcieni, gradientów i kolorów, niż pozwalają na to źródła 8-bitowe. W momencie pisania tego tekstu HDR w swoim pierwotnym znaczeniu jest wyostrzany dokładnie o 10 bitów. Jednak etykieta „HDR Ready” wisi teraz wszędzie, a w sprzedaży jest wiele modeli monitorów HDR z 8-bitowymi matrycami, które w zasadzie po prostu przekręcają gamma i kontrast.

Upraszcza to fakt, że bitowość monitora jest silnie związana z jego ceną. Mówiąc najprościej, 10-bitowe macierze HDR są głównie w segmencie premium i zaczynają się od 500 USD za monitor. Z reguły są to modele 27 i 32-calowe przeznaczone dla wymagających graczy, projektantów i fotografów. W klasie 8-bit + FRC + HDR dominują 27-calowe monitory o nieco bardziej przystępnej cenie. Jeśli szukasz opcji „8-bit + HDR”, możesz uzyskać 200-300 USD za model 24-calowy.

Trudno tu coś konkretnego doradzić, ponieważ każdy ma inne możliwości i wymagania. Zauważamy tylko, że przez ostatnie kilka lat większość ludzi, w tym my, używała zwykłych 8-bitowych monitorów do gier, multimediów i pracy i nikt nie umarł. Fanatyzm jest tutaj bezużyteczny, zakup wyrafinowanego monitora jest uzasadniony tylko wtedy, gdy wyraźnie rozumiesz, dlaczego jest potrzebny. W przeciwnym razie może się zdarzyć, że kabel HDMI lub sterowniki karty graficznej nie obsługują kolorów 10-bitowych.

Gama kolorów / modele kolorów

|

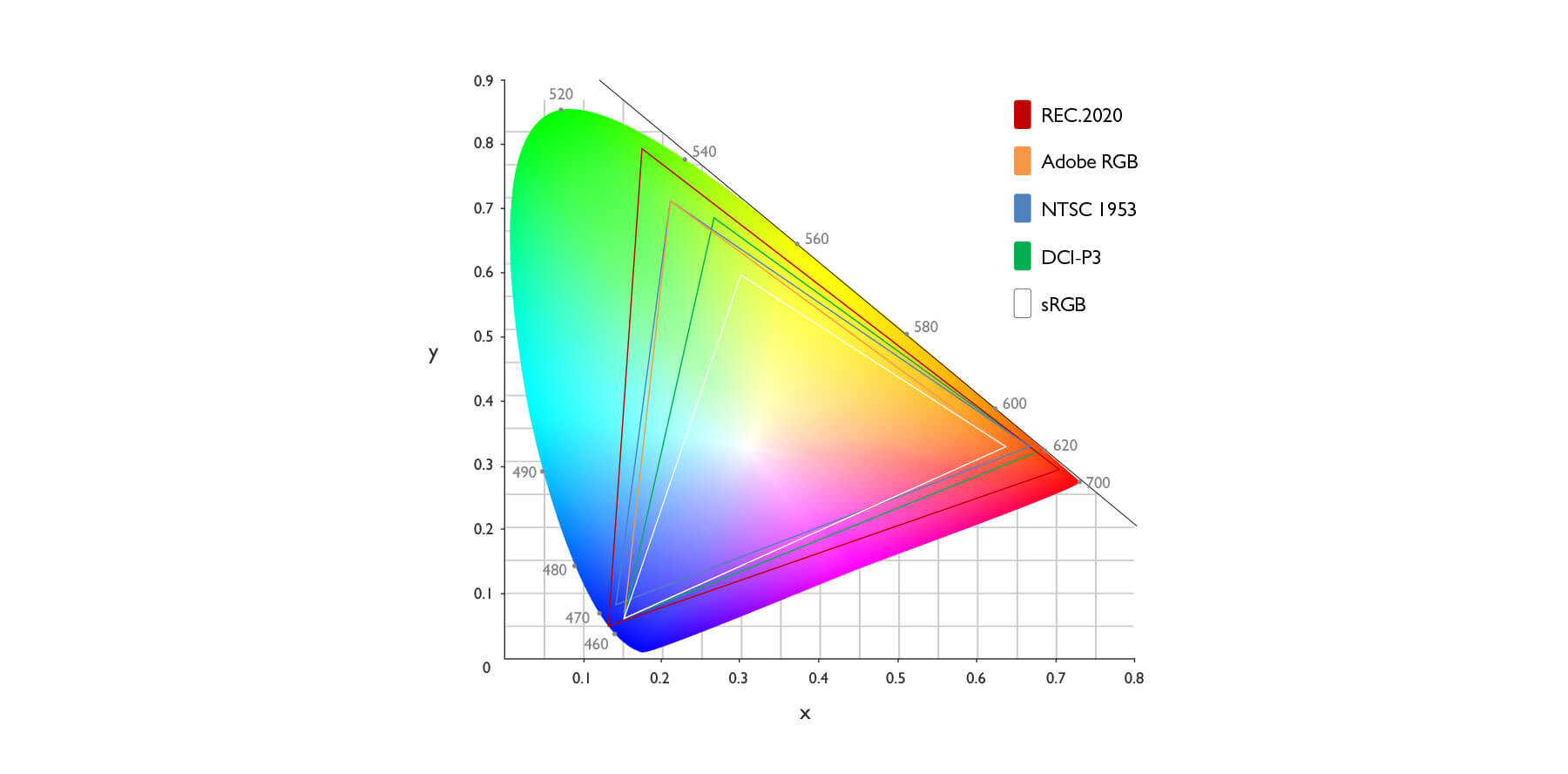

Bez względu na to, jak zaawansowana byłaby dzisiejsza technologia, nadal nie jest ona w stanie dokładnie wyświetlić wszystkich kolorów rzeczywistego świata. Dlatego w opisie monitorów często znajduje się cecha taka jak 117% sRGB lub 99% NTSC 76%. Liczby te pokazują, jak dokładne i szerokie spektrum kolorów jest w stanie wyświetlić monitor oraz jak wysokie jest jego odwzorowanie. Wszystko zaczęło się od wykresu chromatycznego CIE 1931, który składał się ze wszystkich kolorów, które ludzkie oko może rozróżnić. To ona dała początek innym popularnym obecnie modelom kolorystycznym, które znajdują zastosowanie w monitorach, smartfonach, tabletach i innych urządzeniach mobilnych.

sRGB — opracowany w 1996 roku przez HP i Microsoft, standard ten był używany w tamtych czasach w monitorach CRT, drukarkach i Internecie. Wymagano, aby obrazy miały tę samą gamę kolorów i wyglądały tak samo podczas drukowania i oglądania na monitorze. Od tego czasu model kolorów sRGB stał się de facto standardem dla nowoczesnych monitorów: jest używany w projektowaniu i produkcji większości kart graficznych. Jeśli szukasz monitora do pracy z treściami graficznymi, musisz skupić się na pokryciu co najmniej 100% w sRGB. We wszystkich innych przypadkach możesz wziąć coś prostszego, ponieważ rozszerzenie gamy kolorów wpływa na koszt wyświetlacza.

|

NTSC to jeden z pierwszych modeli kolorowych, który jest obecnie częściej używany w porównaniu ze starszymi telewizorami i monitorami. Obecnie rzeczywiste pokrycie większości monitorów LCD wynosi około 75% przestrzeni NTSC, ale istnieją modele z ulepszonym podświetleniem, które pokrywają około 97% przestrzeni kolorów NTSC.

Model Adobe RGB został wymyślony do użytku w drukarni, dzięki czemu jego gama kolorystyczna odpowiada możliwościom technologii druku. Aby z powodzeniem pracować z materiałami ze spektrum Adobe RGB, będziesz potrzebować jego wsparcia zarówno ze strony monitora, jak i oprogramowania. Dlatego patrzenie w stronę monitora z szeroką gamą kolorów według Adobe RGB ma sens przede wszystkim dla tych, którzy zawodowo zajmują się layoutem i projektowaniem wysokiej jakości druku.

Model DCI-P3 przyszedł do nas ze świata kina domowego. To profesjonalny model kolorystyczny, który obecnie służy głównie do pokazania uniwersalnego chłodu wyświetlacza. DCI-P3 pokrywa więcej kolorów niż standardowe sRGB, więc 98% pokrycie gwarantuje odwzorowanie kolorów monitora. Według wielu profesjonalistów, w niedalekiej przyszłości standard ten zastąpi sRGB jako nowy standard dla urządzeń cyfrowych, stron internetowych i aplikacji. Choćby dlatego, że jest aktywnie promowany przez takich gigantów jak Sony, Apple, Google, Warner Bros czy Disney. Ale ponieważ taka technika kosztuje teraz dużo pieniędzy, jest używana głównie przez profesjonalistów pracujących z treściami wideo.

Jaka jest różnica między głębią bitową a gamą?

|

Być może w tym momencie masz pytanie, jaka jest różnica między głębią bitową a gamą kolorów? Łatwo to zrozumieć z powyższego obrazka. Zwiększając głębię koloru zmniejszamy ryzyko ostrych przejść między dwoma odcieniami. Dzięki rozszerzeniu gamutu monitor może wyświetlać bardziej ekstremalne kolory. Zrozumienie tego faktu jest dla Ciebie ważniejsze, ponieważ na rynku nie ma monitorów o niskiej przepływności i szerokiej gamie kolorów. Jak również odwrócone przykłady z dużą głębią bitową i niską gamą kolorów.

Monitory z certyfikatami Pantone i CalMAN

|

Certyfikaty Pantone i CalMAN zainteresują przede wszystkim profesjonalnych projektantów, artystów i kolorystów, ale ominięcie ich byłoby błędem.

W 1963 roku Pantone zmienił sytuację, oferując drukarniom na całym świecie jednolity standard reprodukcji kolorów. Obejmuje 40 kolorów podstawowych i ponad 10 000 odcieni pochodnych, każdy z własną nazwą i słynną kartą kolorów Pantone. Od tego czasu schemat Pantone jest aktywnie wykorzystywany w poligrafii, projektowaniu graficznym, branży modowej, architekturze i wielu innych dziedzinach, które wymagają dokładnego dopasowania kolorów na wszystkich etapach pracy. Właściwie w odpowiedzi na te wymagania pojawiły się monitory, które odwzorowują kolorystykę Pantone ze 100% dokładnością, aby układ zaprojektowany na monitorze projektanta wyglądał tak samo w drukarni.

Z kolei CalMAN to rozwiązanie do kalibracji wyświetlaczy znanej kalifornijskiej firmy Portrait Displays. Ponieważ Pantone historycznie kojarzy się z drukiem, standard CalMAN jest wybierany przez większość profesjonalistów z branży filmowej, telewizyjnej i postprodukcji.

Artykuły, recenzje, przydatne porady

Wszystkie materiały